ムービー レンダー キュー では画像やムービーのレンダリングの幅広い出力形式をサポートしており、一度に異なる形式で出力できます。

前提条件

- 「ムービー レンダー キュー」ページの前提条件の手順を完了している。

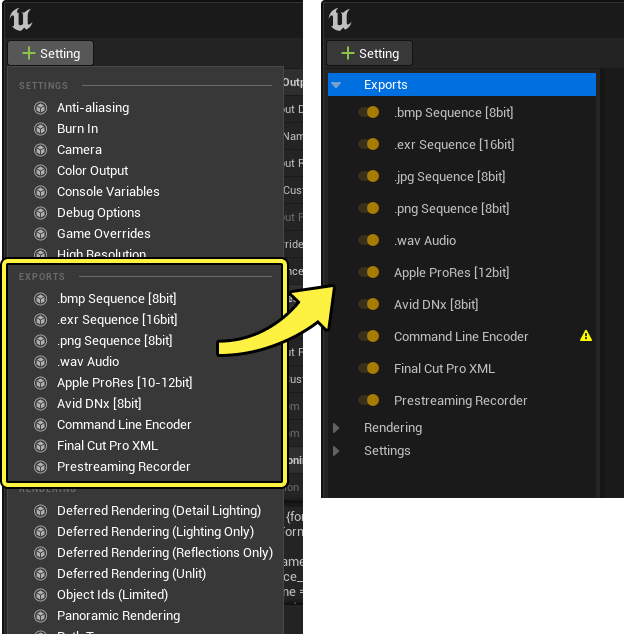

ムービー レンダー キューの [Settings (設定)] ウィンドウで希望のレンダリングの形式を選択できます。これには、[+ Setting (設定)] ドロップダウン メニューをクリックして、 [Export (エクスポート)] カテゴリから形式を選択します。

他の設定と同じように、出力形式の有効/無効を切り替えることができます。これには、出力形式の横にある有効化ボタンをクリックします。また、出力形式を選択すると、そのプロパティ (使用可能な場合) を編集することができます。

次の出力形式を使用できます。

| 名称 | 説明 |

|---|---|

| Command Line Encoder (コマンドライン エンコーダ) | コマンドライン エンコーダを使用すると、FFmpeg などのサードパーティ製ソフトウェアで独自の出力形式を作成できます。この設定には、エンコーダの実行可能ファイルが必要です。また、[Project Settings (プロジェクト設定)] でいくつかの設定を有効にする必要があります。 |

| Final Cut Pro XML (Final Cut Pro で出力した XML) | Final Cut Pro XML 形式は、Final Cut Pro やこの形式をサポートする他のビデオ編集ソフトウェアで読み取り可能な XML ファイルを出力します。これはシッピング ビルドではサポートされていません。 |

| .bmp Sequence [8bit] | ムービーを .bmp 画像のシーケンスとして出力します。ピクセル値は [0-1] の範囲にクランプされるため、HDR 値を保持しません。これは、sRGB エンコーディング カーブを適用します。 |

| EXR Sequence (EXR シーケンス) | ムービーを .exr 画像のシーケンスとして出力します。HDR 値を保持します。ただし、[Tone Curve (トーン カーブ)] が有効な場合、リニア値をほぼ [0-1] の範囲にスケーリングするため、最も明るいハイライトのみが 1 を超えます。[Tone Curve (トーン カーブ)] を無効にすると、ライトの強度やその他の明るいオブジェクトに合わせて [0-100] 以上の範囲のリニア値を書き込みます。.exr の対象には sRGB エンコーディング カーブを適用しません。 |

| .jpg Sequence [8bit] | Outputs the movie as a sequence of .jpgムービーを .jpg 画像のシーケンスとして出力します。sRGB エンコーディング カーブを適用します。 |

| .png Sequence [8bit] | .pngムービーを .png 画像のシーケンスとして出力します。sRGB エンコーディング カーブを適用します。透過性は、[Post Processing (ポストプロセス)] 設定の [Enable Alpha Channel Support (アルファ チャンネル サポートを有効化)] を有効にするとサポートされます。 |

| WAV Audio (WAV オーディオ) | 選択した他のすべての出力形式とともに .wav オーディオ ファイルを出力します。 |

| Apple ProRes Video Codecs (Apple ProRes ビデオ コーデック) | Apple の高品質の非可逆ビデオ圧縮コーデックである Apple ProRes を使用して .mov ファイルを出力します。これには、Apple ProRes Media プラグインを有効化する必要があります。 |

| Avid DNx Video Codecs (Avid DNx ビデオ コーデック) | 高品質の非可逆ビデオ コーデックである Avid DNx を使用してムービー ファイルを出力します。これには、Avid DNxHR/DNxMXF Media プラグインを有効化する必要があります。 |

| Prestreaming Recorder (プレストリーミング レコーダー) | Prestreaming Recorder は、仮想テクスチャ または Nanite でシネマティックスのレンダリング キャッシュを作成するために使用されます。 |

コマンドライン エンコーダ

コマンドライン エンコーダを使用すると、FFmpeg などのサードパーティ製ソフトウェアで独自の出力形式を作成できます。コマンドライン エンコーダを使用するには、[Movie Pipeline CLI Encoder (ムービー パイプライン CLI エンコーダ)] プロジェクト設定に移動して、特定のプロパティおよび設定を行う必要があります。

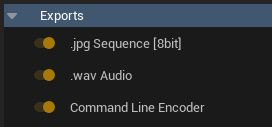

コマンドライン エンコーダを使用する場合は、コマンドライン エンコーダで画像からムービー フレームを作成できるように、コマンドライン エンコーダだけでなく、画像シーケンスのエクスポート形式も必要です。オーディオを含める必要がある場合は、 .wav オーディオ のエクスポートも含める必要があります。

エクスポートの詳細

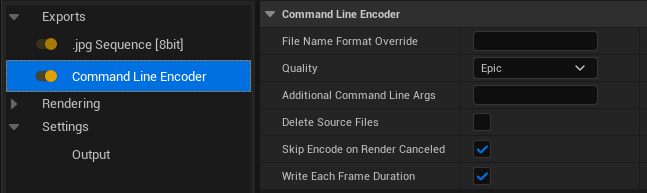

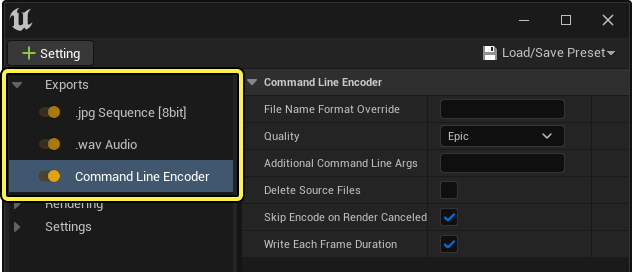

[Command Line Encoder (コマンドライン エンコーダ)] を選択すると、次の詳細が表示されます。

| 詳細名 | 説明 |

|---|---|

| File Name Format Override (ファイル名の形式のオーバーライド) | コマンドライン エンコーダが出力するムービーの [Output (出力)] 設定の [File Name Format (ファイル名の形式)] をオーバーライドします。画像シーケンスを個別のショット フォルダにレンダリングしている場合に、個別のショットのムービー ファイルではなく、1 つのマスター ムービー ファイルを生成する場合に使用します。 |

| Quality (品質) | 使用するエンコーディング品質の設定。これは、 [Movie Pipeline CLI Encoder (ムービー パイプライン CLI エンコーダ)] プロジェクト設定で定義できます。 |

| Additional Command Line Args (追加のコマンドライン引数) | このジョブのエンコーダに渡す追加のコマンドライン引数。 |

| Delete Source Files (ソースファイルの削除) | オンの場合、ムービーのエンコードが完了すると、ソース画像シーケンス ファイルが削除されます。そのため、ソース画像が含まれず、ムービーのみがエクスポートされます。 |

| Skip Encode on Render Canceled (キャンセルされたレンダリングでエンコードをスキップ) | オンの場合、レンダリングが途中でキャンセルされと、エンコーダはレンダリングされたすべてのフレームのエンコーディングを行いません。 |

| Write Each Frame Duration (各フレーム期間を書き込む) | 生成したテクスチャ ファイルに各フレームの持続時間を書き込みます。これは、一部の CLI エンコード ソフトウェアにある一部の入力タイプに必要です。 |

プロジェクト設定

コマンドライン エンコーダを使用するには、特定のプロジェクト設定を行う必要があります。

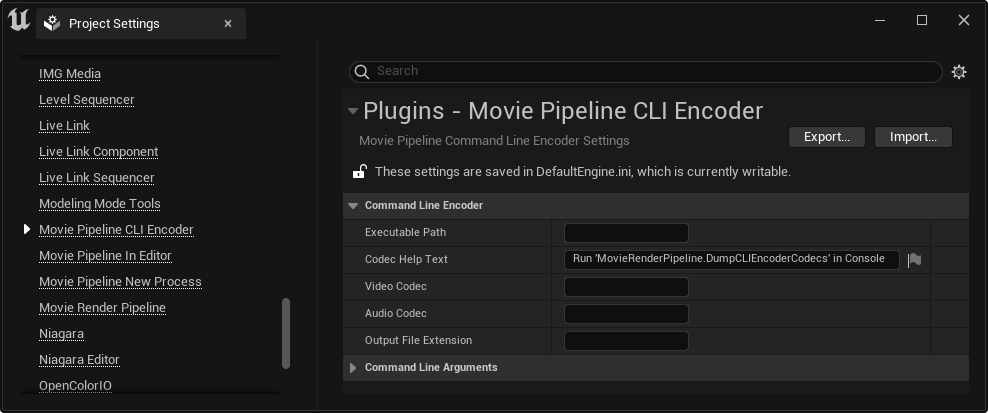

[Edit (編集)] > [Project Settings (プロジェクト設定)] をクリックして [Project Settings (プロジェクト設定)] ウィンドウを開き、 [Plugins (プラグイン)] カテゴリの [Movie Pipeline CLI Encoder (ムービー パイプライン CLI エンコーダ)] に移動します。

| 詳細名 | 説明 |

|---|---|

| Executable Path (実行ファイル パス) | エンコーダの実行可能ファイルのパス (実行可能ファイル名を含む)。

|

| Codec Help Text (コーデック ヘルプ テキスト) | エンコーダに有効なオーディオおよびビデオ コーデックのリストを生成するために、Unreal のコンソール ウィンドウに貼り付けるプロジェクト用のテキスト。コマンドが実行可能ファイルをクエリする際に、最初に Executable Path (実行可能ファイル パス) を設定する必要があります。 |

| Video Codec (ビデオ コーデック) | ビデオ コーデックを指定します。FFmpeg を使用する場合は、Unreal の [Output Log (アウトプットログ)] ウィンドウで MovieRenderPipeline.DumpCLIEncoderCodecs を実行することで、コーデックのリストを確認することができます。 |

| Audio Codec (オーディオ コーデック) | オーディオ コーデックを指定します。FFmpeg を使用する場合は、Unreal の [Output Log (アウトプットログ)] ウィンドウで MovieRenderPipeline.DumpCLIEncoderCodecs を実行することで、コーデックのリストを確認することができます。コマンドラインで -acodec {AudioCodec} を指定している場合は、オーディオ コーデックを指定する必要があります。 |

| Output File Extension (出力ファイル拡張子) | 出力ファイルの拡張子。mp4 、 mkv 、または webm などのピリオドは含みません。コーデックによっては異なるコンテナをサポートしている場合がありますので、使用しているコーデックに適したコンテナを使用してください。 |

| Command Line Format (コマンドライン形式) | 起動するための最終コマンドライン引数を作成する際に使用する形式文字列。

|

| Video Input String Format (ビデオ入力文字列形式) | ビデオ入力引数を作成する際に使用する形式文字列。

|

| Audio Input String Format (オーディオ入力文字列形式) | オーディオ入力引数を作成する際に使用する形式文字列。

|

| Encode Settings Low (エンコード設定 低) | Command Line Encoder の詳細にある Quality プロパティで Low が指定されている場合に使用するエンコード引数。 |

| Encode Settings Med (エンコード設定 中) | Command Line Encoder の詳細にある Quality プロパティで Med が指定されている場合に使用するエンコード引数。 |

| Encode Settings High (エンコード設定 高) | Command Line Encoder の詳細にある Quality プロパティで High が指定されている場合に使用するエンコード引数。 |

| Encode Settings Epic (エンコード設定 エピック) | Command Line Encoder の詳細にある Quality プロパティで Epic が指定されている場合に使用するエンコード引数。 |

エンコード設定は、使用しているコーデックに応じて異なる場合があります。デフォルト値は、FFmpeg と併用できる最も一般的なコーデックの一般的な設定と考えられているものです。コマンドライン エンコーダでは、シングル パス エンコードのみサポートしています。コーデックおよびコーデックのエンコーディング設定の詳細については、『FFmpeg Codec Documentation』を参照してください。

設定例

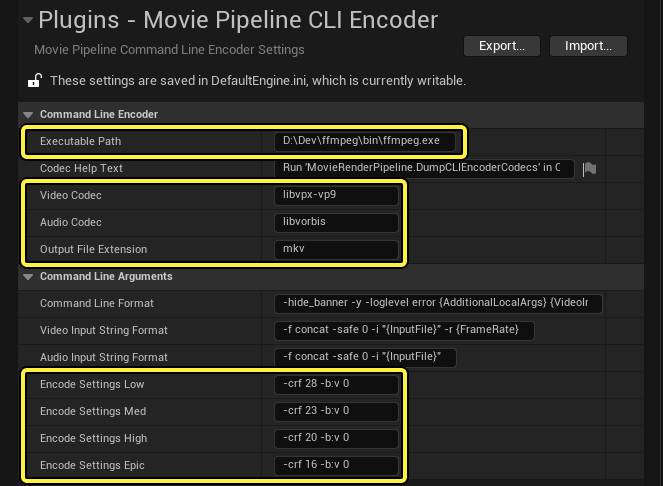

次の画像で、オープン形式の VP9 コーデックで ffmpeg を使用するようにエンコーダを設定する必要がある場合の、詳細およびプロジェクト設定の例を示します。

この例では、 コマンドライン エンコーダ が、 .jpg シーケンス および .wav オーディオ と一緒にエクスポートされることを確認できます。

[Project Settings (プロジェクト設定)] では、ハイライトされているプロパティのみが、コーデックをサポートするためにデフォルト値から変更されています。.wav オーディオ パスをエクスポートしない場合は、オーディオ コーデックを指定する必要はありません。

- Video Codec:

libvpx-vp9 - Audio Codec:

libvorbis - Output File Extension:

mkv - Encode Settings Low:

-crf 28 -b:v 0 - Encode Settings Med:

-crf 23 -b:v 0 - Encode Settings High:

-crf 20 -b:v 0 - Encode Settings Epic:

-crf 16 -b:v 0

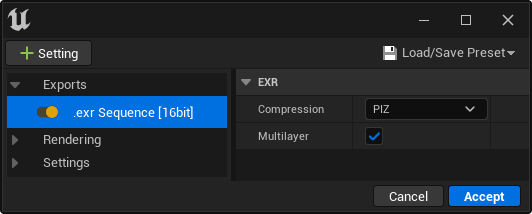

EXR シーケンス

Unreal では、ムービー レンダー キューの出力形式として .exr 画像シーケンスをサポートしています。EXR シーケンスは、Nuke、Tweak RV、IfranView、ProEXR プラグインを備える Adobe Premiere など、幅広いビジュアル エフェクト パッケージに対応しています。

現在、EXR 出力では次の圧縮設定をサポートしています。

| EXR | 説明 |

|---|---|

| None (なし) | .exr シーケンスのレンダリング出力に圧縮が適用されません。 |

| PIZ | 粒子の粗い画像に適した品質を提供する可逆圧縮形式。 |

| ZIP | ノイズの少ない画像に適した品質を提供する可逆圧縮形式。 |

また、Unreal では、マルチレイヤー .exr 出力の使用もサポートしています。複数の異なる を有効にすると、それぞれの設定が .exr シーケンスに埋め込まれ、外部のビジュアル エフェクト編集プログラムから個別にアクセスできるようになります。

すべてのソフトウェアでマルチレイヤー .exr ファイルがサポートされているわけではありません。サポートされていない場合は、.exr をロードしてもデフォルトの RGBA チャンネルのみが表示されます。マルチレイヤー .exr をサポートしていないプログラムを使用している場合は、Multilayer (マルチレイヤー)設定をオフにすると、各レイヤーを個別の .exr ファイルとして書き出すことができます。

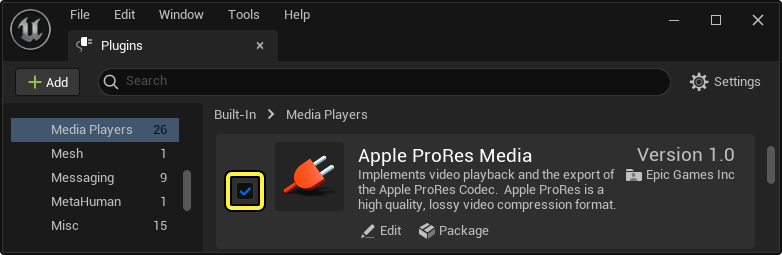

Apple ProRes ビデオ コーデック

Apple ProRes は、ポストプロダクション エフェクトやビジュアル エフェクトのための Apple の高品質の非可逆ビデオ圧縮形式で、最大 8k のビデオをサポートしています。

このツールを使用するには、このツールのプラグインを有効にする必要があります。Unreal Engine メニューで [Edit (編集)] ] > [Plugins (プラグイン)] に移動し、 [Media Players (メディア プレイヤー)] セクションで [Apple ProRes Media] を見つけて有効にします。有効にしたら、エディタを再起動する必要があります。

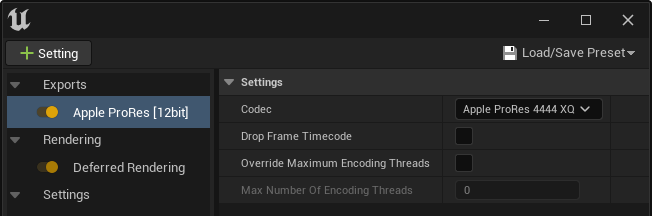

これで、 [Settings (設定)] メニューで [Apple ProRes [10-12bit]] を使用できるようになります。この出力形式を選択すると、レンダーによって、それぞれが異なるレベルの圧縮と品質を提供する複数のコーデックのいずれか 1 つを使用してビデオ ファイルが出力されます。ビデオ コンテナは .mov です。

[Codec (コーデック)] ドロップダウンをクリックして、出力ビデオ ファイルに必要なコーデックを選択します。次のコーデックを使用できます。

| コーデック | ピクセル深度 | 1080p および 30 fps での推定ビットレート | 説明 |

|---|---|---|---|

| Apple ProRes 422 Proxy | 10 ビット | 45 mbps | 最も高い圧縮率。データ レートは低いものの、フル解像度のビデオが必要なオフライン ワークフローに適しています。 |

| Apple ProRes 422 LT | 10 ビット | 100 mbps | Apple ProRes 422 のより圧縮されたバージョン。ファイル サイズは推定で約 30% 削減されます。ストレージとデータ レートが限られている環境での使用に適しています。 |

| Apple ProRes 422 | 10 ビット | 150 mbps | フルワイド 4:2:2 のビデオ ソース向けの高品質の圧縮。マルチストリームのリアルタイム編集に適しています。 |

| Apple ProRes 422 HQ | 10 ビット | 220 mbps | Apple ProRes 422 の高ビットレート バージョン。4:2:2 ビデオ ソース用という点を除き、ProRes 4444 と同レベルの品質を提供します。 |

| Apple ProRes 4444 | 12 ビット | 330 mbps | 4:4:4:4 画像ソース用の高品質圧縮形式。きわめて高品質の画像を提供し、アルファ チャンネルをサポートしています。出力ファイルのサイズが非常に大きくなります。 |

| Apple ProRes 4444 XQ | 12 ビット | 500 mbps | アルファ チャンネルをサポートしている最高品質のストレージ。RGB チャンネルの精度は 12 ビットで、アルファ チャンネルの精度は 16 ビットです。出力ファイルのサイズがきわめて大きくなります。 |

これらの各コーデックの詳細については、『Apple's documentation on Apple ProRes』を参照してください。

[Drop Frame Timecode (ドロップ フレーム タイムコード)] 設定は、タイムコード トラックをドロップフレーム形式を使用するように設定します。これは、シーケンスのフレームレートが 29.97 の場合にのみ適用されます。

[Override Maximum Encoding Threads (最大エンコーディング スレッドをオーバーライド)] をオンにすると、[Max Number of Encoding Threads (エンコーディング スレッドの最大数)] を手動で設定することができます。これは、ビデオ ファイルのエンコーディング プロセスでコーデックが使用できる CPU スレッドの最大数を設定します。より多くのスレッドを使用するとより迅速にエンコーディングが行われますが、CPU 使用率は高くなります。

Apple ProRes ではオーディオをエクスポートしません。[.wav Audio (WAV オーディオ)] のエクスポート設定を追加して、ビデオと一緒に個別の .wav ファイルを出力して、ポストプロダクションでそれらを結合することができます。

Avid DNx ビデオ コーデック

Avid DNxHR と DNxMXF は、ポストプロダクション用の Avid の高解像度非可逆ビデオ コーデックで、最大 8K のビデオをサポートしています。

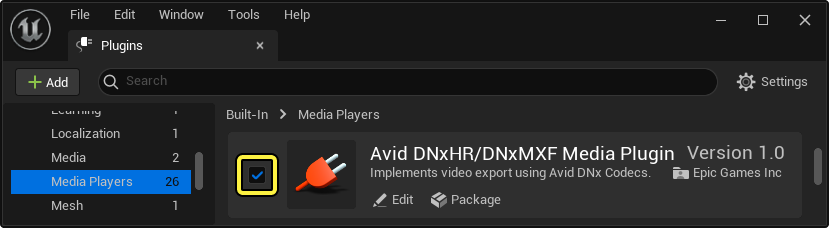

Avid DNx ビデオ コーデックを使用するには、Avid DNx ビデオ コーデックのプラグインを有効にする必要があります。Unreal Engine メニューで [Edit (編集)] ] > [Plugins (プラグイン)] に移動し、 [Media Players (メディア プレイヤー)] セクションで [Avid DNxHR/DNxMXF Media Plugin] を見つけて有効にします。有効にしたら、エディタを再起動する必要があります。

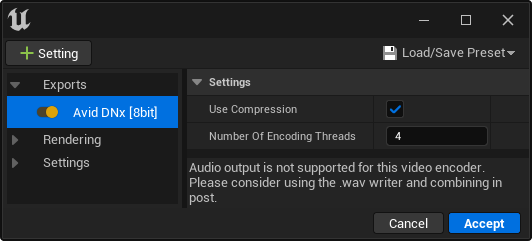

これで、出力設定として Avid DNx [8bit] を使用できるようになりました。この設定を選択すると、ムービーが Avid の DNx コーデックを使用するビデオ ファイルとして出力されます。ビデオ コンテナは .mxf です。

[Use Compression (圧縮を使用する)] をオンにすると、非可逆の圧縮ファイルが出力され、オフにすると可逆の圧縮されないファイルが出力されます。[Number of Encoding Threads (エンコーディング スレッド数)] を変更すると、コーデックでエンコーディングに使用する CPU スレッド数を制御できます。より多くのスレッド数を使用すると、ファイルをエンコードするのに必要な時間は短縮されますが、結果として CPU 使用率が高くなります。

このコーデックおよび仕様に関する詳細については、『Avid's documentation on the DNx video codecs』を参照してください。

Avid DNx ではオーディオをエクスポートしません。[.wav Audio (WAV オーディオ)] のエクスポート設定を追加して、ビデオと一緒に個別の .wav ファイルを出力して、ポストプロダクションでそれらを結合することができます。現在のところ、Avid DNx では、コーデックを問わず 8 ビット精度のみをサポートしています。

Final Cut Pro XML

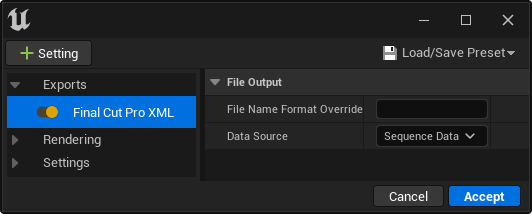

Final Cut Pro XML 形式は、Final Cut Pro やこの形式をサポートする他のビデオ エディタで読み取り可能な XML ファイルを出力します。コマンドライン エンコーダと同様に、このエクスポート形式に伴う画像シーケンスまたはビデオ ファイルの出力を指定する必要があります。

出力ファイルの名前の {token} を指定するには、[File Name Format Override (ファイル名形式のオーバーライド)] フィールドを使用します。これらのトークンは、 [Output (出力)] 設定のトークンに基づいています。

[Data Source (データ ソース)] ドロップダウン メニューでは、Final Cut Pro XML ファイルの作成方法を指定します。この方法では、ファイルにどのデータを埋め込むか、どのような形式にするかを決定します。

| データ ソース | 説明 |

|---|---|

| Output Metadata | オリジナルのレベル シーケンスデータに基づくのではなく、実際にディスクに書き込まれたファイルに基づいて XML ファイルをビルドします。これは時間の遅れトラックをサポートしています (そのため、シーケンサの実際のショット セクションよりもショットのフレーム数が増減します) が、後でシーケンサに再インポートすることはサポートしていません。 |

| Sequence Data | シーケンス データから直接 XML ファイルを作成します。再インポートでの使用に適しています。 |

Final Cut Pro XML は Unreal Editor の出力形式としてのみサポートされています。この形式は、エディタ専用機能に依存しているため、シッピング ビルドには使用できません。

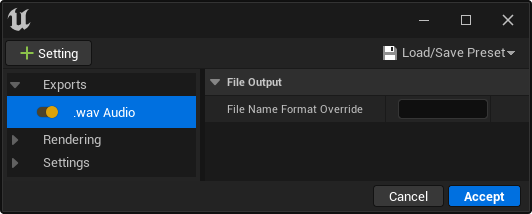

WAV オーディオ

追加のレンダリング パスを必要とすることなく、シーケンスの .wav オーディオをエクスポートできます。このため、ムービーのオーディオを出力して、ポストプロダクションで画像シーケンスと結合することができます。

[File Name Format Override (ファイル名形式のオーバーライド)] フィールドを使用すると、エクスポートされた .wav ファイルの [Output (出力)] 設定の [File Name Format (ファイル名の形式)] をオーバーライドできます。

WAV オーディオ出力形式は実験段階の機能であり、プロダクション レベルに達していない可能性があります。ムービー レンダラは、ウォームアップ フレームのためにショット間でエンジンを実行するため、シーケンサで制御されていないオーディオはショット間にギャップが生じます。また、シーケンサでオーディオ クリップに若干のオーディオ ディストーションがショット間で発生することがあります。

カスタム出力形式

独自の形式を作成するには UMoviePipelineOutputBase クラスを実装します。このクラスはバーンイン、UI ウィジェット、最終画像など、該当フレームにレンダリングするレンダリング パスをすべて含む各出力フレームへのコールバックを提供します。このクラスをプロジェクトのコードに実装すると、自動的に [Settings (設定)] メニューに表示され、使用できるようになります。MovieRenderPipelineCore モジュールとリンクする必要があります。

UI で作成されたすべての新しいジョブにこの出力形式を確実に追加するには、[Movie Render Pipeline Project (ムービー レンダ パイプライン プロジェクト)] 設定で指定されている [Default Job Setting Classes (デフォルトのジョブ設定クラス)] を調整してください。

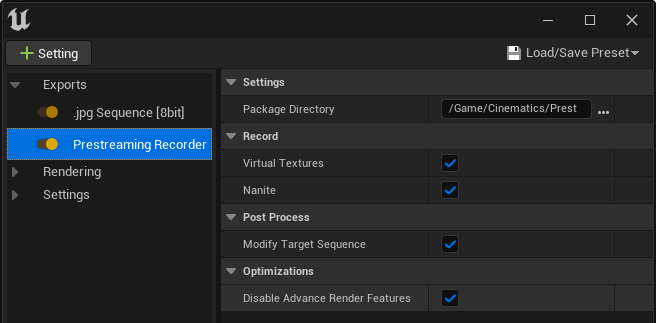

プレストリーミング レコーダー

[Prestreaming Recorder (プレストリーミング レコーダー)] オプションは、シネマティック プリストリーミング プラグイン を有効にしているときのみ使用可能です。仮想テクスチャ と Nanite でシネマティックス向けのレンダー キャッシュ作成に使用します。

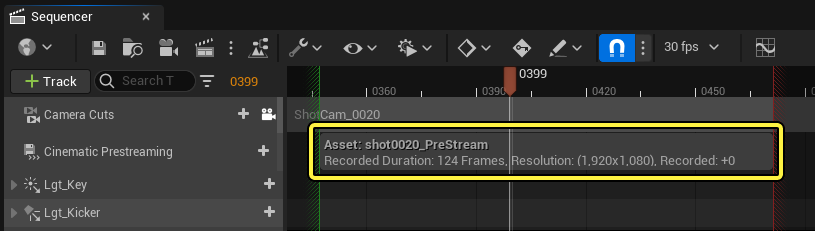

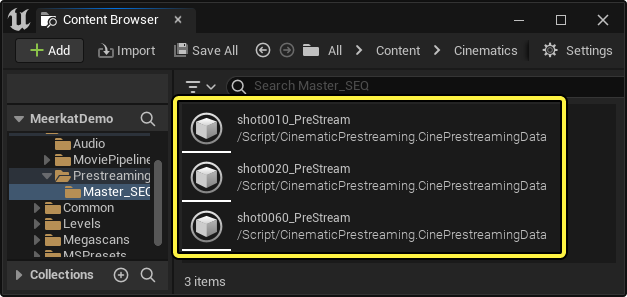

仮想テクスチャと Nanite のデータのストリーミング方法のため、最初に Prestreaming Recorder を使用してレンダリングし、シネマティック プリストリーミング システムが解釈するキャッシュをビルドする必要があります。このキャッシュは自動的に保存され、レンダリングされるシーケンス内で参照されます。これにより、シーケンサーはこのデータを使用して、必要になる前にフレームに必要なコンテンツを仮想テクスチャと Nanite システムに通知します。それにより、フレームがレンダリングされるときに必要なデータがすでに GPU に存在するようにします。これが存在しない場合、Nanite と仮想テクスチャが表示されてから目標の品質に達するまでに遅延が生じ、シネマティックス中にテクスチャとジオメトリの解像度や品質が低下する可能性があります。

プリストリーミング キャッシュのビルドは、MRQ レンダリングのためだけのものではありません。Cinematic Presteaming トラックとそのデータ キャッシュは、仮想テクスチャのストリーミングをリアルタイム シーケンスで通知することもできます。キャッシュにはその時点でレンダリングされたもののデータのみが含まれるため、これにはリアルタイム シネマティクスがほぼ決定論的である必要があります。キャッシュに利用可能なデータがない場合、これらのシステムで見られる通常のランタイム レイテンシに戻ります。

Prestreaming Recorder には、次のプロパティがあります。

| データ ソース | 説明 |

|---|---|

| Package Directory (パッケージ ディレクトリ) | シネマティック プリストリーミング データ キャッシュを保存するための、プロジェクト ルート フォルダに相対的なディレクトリ。これは  |

| Virtual Textures (仮想テクスチャ) | 仮想テクスチャ ページ リクエストのキャプチャを有効にします。これを無効にすると、シネマティック プリストリーミング キャッシュをビルドするために仮想テクスチャの情報が収集されなくなります。 |

| Nanite | Nanite リクエストのキャプチャを有効にします。これを無効にすると、シネマティック プリストリーミング キャッシュをビルドするために Nanite の情報が収集されなくなります。 |

| Modify Target Sequence (ターゲット シーケンスの変更) | シネマティック プリストリーミング レコーダーを有効にして、レンダリングの完了後にキャッシュ プレイ データをレベル シーケンスに自動的に追加します。 |

| Disable Advance Render Features (高度なレンダリング機能を無効) | 有効にすると、ライティング、ポストプロセス、反射などのいくつかのレンダリング機能が無効になります。これらを無効にすると、レンダリングは高速化されますか、実際の出力レンダリング イメージは非常に簡素になり使い物にならなくなります。 プリストリーミング レコーダーの主な目的は、レンダリングではなく シネマティック プリストリーミング キャッシュ をビルドすることであることから、これを有効にすると便利です。 |

Nanite および仮想テクスチャは画面解像度に依存します。つまり、正確なキャッシュ データを生成するには、ターゲット解像度でプリストリーミング レコーダーを使用してシネマティックスをレンダリングする必要があります。オブジェクトの変換、マテリアルの編集、その他の変更など、コンテンツが大幅に変更された場合も、再レンダリングする必要があります。

VT Pending Mips (Debug) (VT ペンディング ミップ (デバッグ)) レンダー パスを追加することもできます。これを使用すると、追加のフレームを出力ディレクトリにエクスポートできます。これらのフレームは、仮想テクスチャのミップ情報のデバッグに使用できます。